최근 인공지능 업계의 화두는 단연 "에이전트 AI"이다. 즉 기존의 말만 할 줄 아는 인공지능을 넘어서 직접 행동을 할 줄 아는 인공지능으로의 진보가 소위 "강 인공지능"으로의 한발자국 더 나아간다는 측면에서 크게 주목을 받는 것이다. 그러면서도 항상 같이 언급되는 건 AI의 무지막지한 에너지 사용량이다. 주식으로 보면 펀터멘털 모델을 가진 인공지능 테마주도 뜨겁고 그들을 등에 업고 있는 원자력 등 에너지 테마주도 뜨겁다.

진짜 이대로 괜찮을까? 라는 생각이 든다. 하지만 아직까지는 무지막지하게 전기를 먹고 엄청나게 무거운 계산을 할지언정 성능상의 한단계 진보가 더 급하지 연산 효율에 관해서는 되돌아보기 힘든 바쁜 레이스이다. 사실 이면엔 성능상의 진보다 급하다는 이유 말고도, 이 펀더멘털한 거대 모델들을 빅테크 기업들이 독점하고자 하는 욕심이 깔려 있기도 하다. 알만한 사람들은 알겠지만 지금의 상용 LLM 모델들은 빅테크가 아니면 도저히 훈련시켜서 만들어볼 생각조차 하지 못할 정도로 너무 거대하다. 한국에도 이를 비벼볼 수 있는 곳은 네이버, 카카오, 삼성, LG, SK 정도이다. 그마저도 자본력이 압도적인 해외 빅테크에 비해선 한참 뒤쳐진다.

만약 빅테크들에서 인공지능의 효율에 대해 심각하게 파고 들었다면, 어쩌면 우리나라 벤처기업에서도 한번 해볼만한 좋은 방안들이 나왔을지도 모른다. 하지만 그들은 모두가 참여해서 같이 발전해 나가자 보단 우리가 독점하겠다는 심보가 있다. 그래서 논문을 봐도 아이디어는 공개 될지언정 실제로는 중요한 정보나 데이터들은 그들만 가지고 있어 재현이 힘든 경우가 많다. 최근 발표되는 상용 모델들은 심지어 파라미터 수조차도 비공개이다. 그럼 이들을 따라하기 위해 필요한 것은 무엇인가? 무지막지만 시행착오뿐이다. 하지만 이를 감당할 수 있는 회사는 많지 않다.

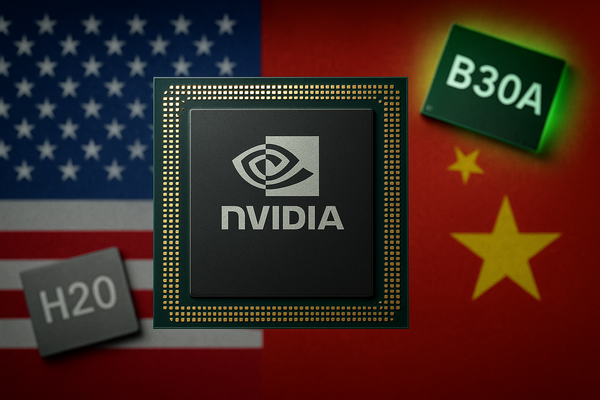

우리가 뉴스에서 매일 보는 사람 (또는 회사) 중에 유일하게 효율에 대해 외치고 있는 사람은 NVIDIA의 황사장님 뿐이다. 그들은 AI를 직접 진보시키는 역할이라기 보단 이를 가능케 하는 Enabler의 역할이기 때문이다. NVIDIA가 잘 하면 모두가 균등하게 좋아진다. 이는 소프트웨어가 아닌 하드웨어 측면에서의 효율성 개선이다. 이런 진보는 GPU의 의존성을 강화한다. 결국 GPU를 가진 자들만 생존하고 앞서나갈 수 있도록 한다. 그래서 미국은 중국으로 좋은 GPU가 가는 것을 그렇게도 싫어한다.

중국 이야기를 하나 보디 효율을 외치고 있는 또 다른 누군가가 떠오른다. 바로 "중국"의 회사, 연구자들이다. 그들은 유난히 효율에 관심이 많다. 딥시크의 사례를 봐도 알 것이다. 딥시크가 발표되고 그렇게 빅테크의 주식이 폭락했던 것은, 빅테크와 월가 모두 이정도의 성취는 기득권이 있는 우리들만이 할 수 있었다고 믿었던 것을 중국이 해내버렸기 때문이다. 딥시크는 물론 그들이 말한 걸 100% 신뢰할 수 없다 하더라도, 상대적으로 적은 자원으로 상대적으로 큰 일을 이뤄낸 것만은 분명하다. MoE 등 호율성을 추구할 수 있는 다양한 기술등을 총 망라했다.

하지만 이는 중국만의 일이 아니다. 미국에 비해 자본력이나 기반 기술 자체가 뒤쳐진 우리나라에서도 신경을 써야 할 분야이다. LLM 같은 거대 모델들은 지금보다 효율화될 여지가 많다. 하지만 현재 품질 경쟁이 심하다 보니 빅테크들에선 성능에 트레이드 오프가 조금이라도 있는 효율화는 적극적으로 적용하지 않는 측면이 있다. 안그래도 최신·최고급 모델조차 할루시네이션이 해결되지 않는데 돈 좀 아끼겠다고 효율화를 추구했다간 최근 GPT-5처럼 욕만 엄청나게 먹을 가능성이 높기 때문이다.

하지만 우리는 해야 한다. 우리는 어찌 보면 중국보다 훨씬 가난한 나라이다. 적은 돈으로도 비록 미국의 탑급 펀더멘털 모델만큼은 아니라도 쓸만한 모델들이 나와줘야 그 서비스를 국민들이 이용할만 할 것이고, 나라에서도 펀딩을 해줄만한 여지가 생기는 것이다. 난 최근 정부가 AI를 지원한다고 했을 때 혹여라도 해외 펀더멘털 모델 가져다가 프롬프트만 열심히 만들고 RAG만 가져다 붙이는 그런 서비스들을 지원할까봐 겁이 날 정도였다.

효율적인 AI는 단순히 학습을 가능케할 뿐만 아니라, 더 나아가서는 모델 경량화를 통해 스마트폰이나 PC 로컬에서 서버로 민감한 정보를 전송하지 않고 추론이 가능한 서비스를 우리에게 가져다줄 수도 있다. 엣지 디바이스에서의 학습, 추론 등은 그 잠재력이 무궁무진한 분야이다. 성능에 조금 트레이드 오프가 있을지언정 기존에 못하던 것을 가능케하는 특이점 수준의 경량화를 이룬다면 그건 해외의 탑급 펀터멘탈 모델들과 경쟁하는 비대칭 전력이 될 수 있다.

원래는 경량화에 사용되는 계산법이나 경량화의 효과 등에 대해 기술적으로 간단히 소개하는 글을 쓰려고 했는데 사족이 너무 길어졌다. 이 내용은 이어서 다음 글에 작성하도록 하겠다.

'IT 기술 정보' 카테고리의 다른 글

| 인공지능 효율화 기법. 계산량이 얼마나 줄어들까? (0) | 2025.10.27 |

|---|---|

| 인공지능(특히 신경망)의 계산 단위 FLOP과 MAC (0) | 2025.10.24 |

| AWS re:Invent 참석자 가이드 및 알고가면 좋은 팁들 (1) | 2024.09.18 |

| 개인정보 유출사고 위반 종합선물 세트 사례 (0) | 2021.12.14 |

| 비밀번호의 길이를 제한해선 안 된다. (feat. 네이버) (0) | 2021.11.05 |